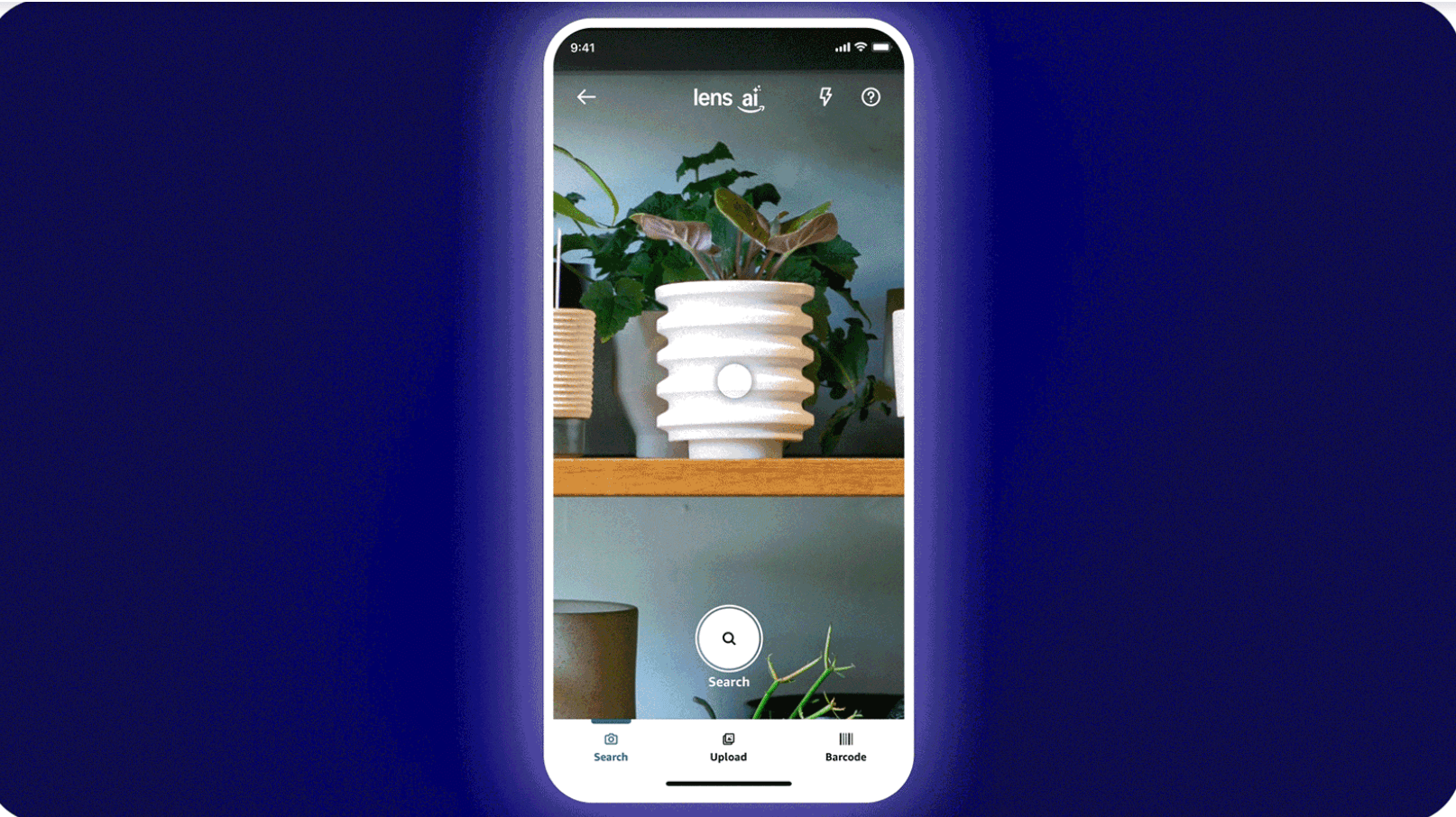

想象一下:你正走过邻居漂亮的户外花盆,你不用尴尬地问他们在哪里买的,而是把手机对准它。亚马逊会立即向您展示数十个类似的选项,包括价格和一键购买。这就是的承诺从今天开始,该功能将向数千万 iOS 用户推出。

这家零售巨头的新工具将传统的 Amazon Lens 体验转变为真正具有未来感的体验。 Lens Live 不再采用旧的“快照并等待”的方法,而是在您打开相机的那一刻开始扫描产品,并在屏幕底部的可滑动轮播中显示匹配的商品。视觉搜索实际上跟上了我们自然浏览周围世界的方式。

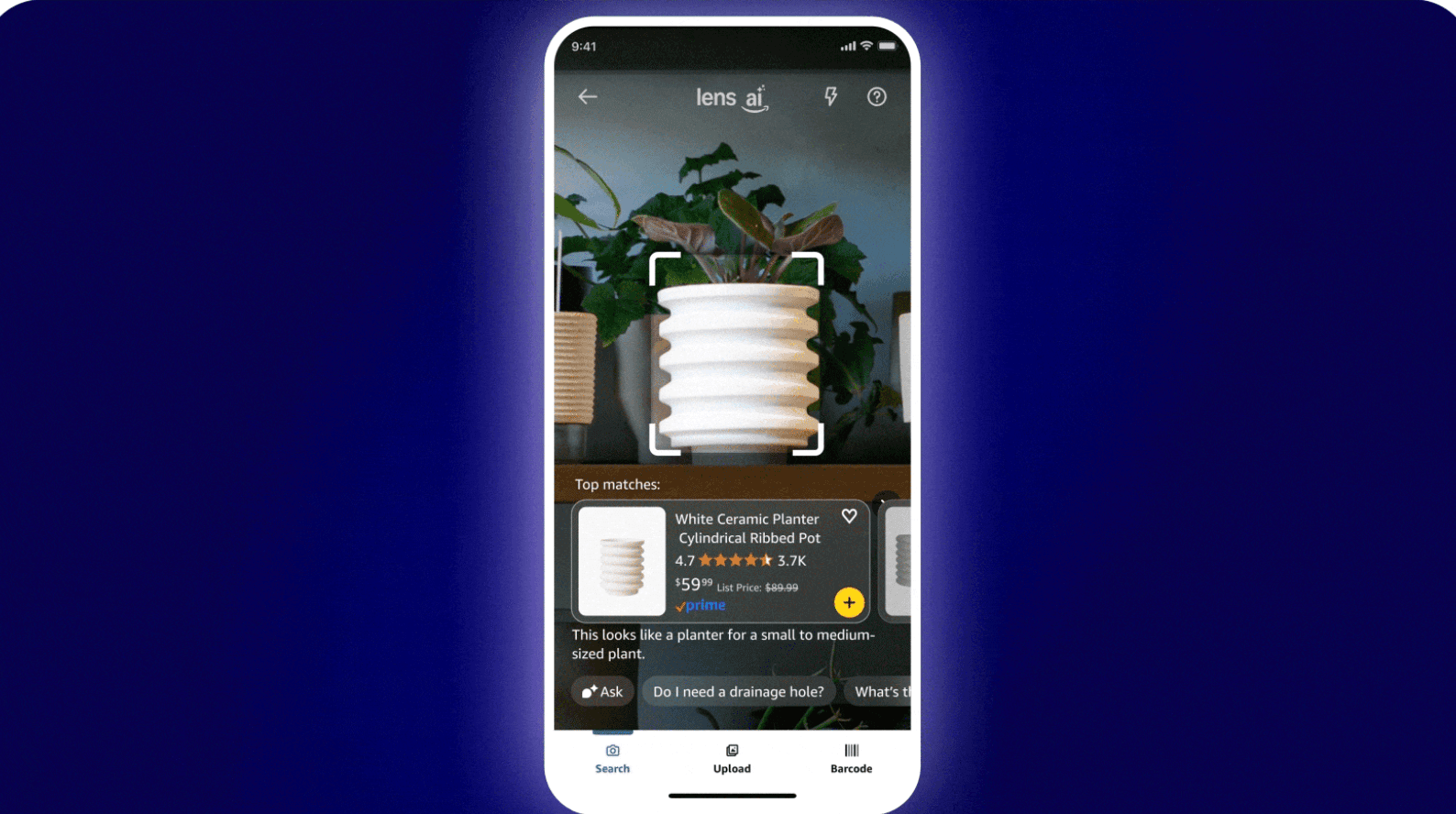

与之前的视觉搜索尝试的不同之处不仅在于速度,还在于与。当您将相机对准陶瓷花盆时,鲁弗斯会插话,提供上下文建议和总结,说明特定产品值得考虑的因素。 AI 助手可以回答有关材料、尺寸或保养说明的问题,而无需强迫您离开摄像头视图。

点击展开

从本质上讲,Lens Live 代表了移动人工智能领域的一项重大技术成就。该系统直接在您的设备上运行轻量级计算机视觉模型,实时识别对象,然后将其与亚马逊目录中的数十亿产品进行匹配。这种设备上处理意味着初始检测会立即发生,不会出现通常与基于云的图像识别相关的延迟。

点击展开

Amazon 的工程团队在 AWS 基础设施上构建了该功能,利用 OpenSearch 和 SageMaker 大规模部署必要的机器学习模型。为匹配过程提供动力的视觉嵌入模型经过专门训练,可以处理现实世界环境的混乱——变化的照明条件、局部视图以及奇怪角度的产品,这些通常会混淆传统的图像识别系统。

与 Rufus 的集成又增加了一层复杂性。亚马逊一直在全球稳步推出的购物助手使用大型语言模型来理解上下文并生成相关的产品见解。当与 Lens Live 结合使用时,它创造的购物体验更像是有一位知识渊博的朋友帮助您浏览,而不仅仅是另一个搜索界面。

对于担心传统 Lens 功能消失的用户,亚马逊保留了所有现有选项。如果您愿意,您仍然可以拍照、上传现有图像或扫描条形码。该公司似乎明白不同的购物场景需要不同的方法——有时您希望在积极购物时立即获得结果,有时您正在研究之前拍摄的照片。

推出策略表明亚马逊对此次推出持谨慎态度。从数千万 iOS 用户开始可能听起来规模很大,但对于亚马逊这样规模的公司来说,这实际上是一个受控部署。逐步扩展使他们能够收集反馈并根据现实世界的使用模式完善人工智能模型。尽管亚马逊承诺该功能将在未来几个月内向所有美国客户推出,但 Android 用户将不得不等待更长的时间。

对于人工智能驱动的购物工具来说,此次发布正值一个有趣的时刻。零售行业一直在竞相整合生成式人工智能功能,从 eBay 到小型初创公司,每个人都推出了自己的视觉搜索和人工智能助理工具。亚马逊的优势在于其庞大的产品目录和购物数据,可以根据实际购买行为而不仅仅是浏览模式来训练其模型。

真正的考验将是 Lens Live 是否真的会改变购物行为,或者成为应用程序中另一个很少使用的功能。访问该功能的早期采用者报告说,实时扫描感觉非常自然,尤其是对于视觉相似性比精确匹配更重要的家居装饰和时尚物品。只需点击一下即可将商品直接添加到购物车或将其保存到愿望清单而无需离开相机视图,从而消除了发现到购买流程中的重大障碍。

注重隐私的用户可能会喜欢初始对象检测发生在设备上,尽管实际的产品匹配和 Rufus 交互仍然需要云处理。亚马逊尚未详细说明存储哪些视觉数据或如何使用它来改进服务,随着更多用户获得该功能,这可能会成为一个更大的话题。

对于亚马逊来说,Lens Live 不仅仅代表了一个很酷的技术演示,它还是一个捕捉当前逃离其生态系统的购物时刻的战略游戏。每当有人在现实世界中看到他们喜欢的东西但不知道如何搜索它时,这就是一次潜在的销售因摩擦而丢失。通过使视觉搜索变得即时和对话,他们相信可以将更多转瞬即逝的购物冲动转化为实际购买。

该功能作为,加入其他最近推出的产品,例如个性化购物提示和人工智能生成的产品描述。这些工具共同描绘了亚马逊对电子商务未来的愿景:更少的打字,更多的发现,以及人工智能助手,即使您自己无法完全描述它,也能真正理解您正在寻找的东西。