研究人员发现 AI 编码工具存在 30 多个安全漏洞

安全研究人员在一系列人工智能驱动的编码工具和 IDE 扩展中发现了 30 多个严重漏洞,这些漏洞可用于数据盗窃、配置篡改和远程代码执行 (RCE)。

新发现的漏洞类别被该发现背后的研究人员 Ari Marzouk (MaccariTA) 称为“IDEsaster”,它展示了如何通过提示注入来操纵 AI 代理以滥用合法的 IDE 功能。

这些漏洞涉及 Cursor、Windsurf、Kiro.dev、GitHub Copilot、Zed.dev、Roo Code、Junie、Cline、Claude Code 和 Gemini CLI 等流行工具。研究人员发现,100% 的测试 AI IDE 都存在漏洞,迄今为止已分配了 24 个 CVE。

“我认为,多个通用攻击链影响了每个测试的 AI IDE,这是这项研究中最令人惊讶的发现,”Marzouk 告诉《黑客新闻》。

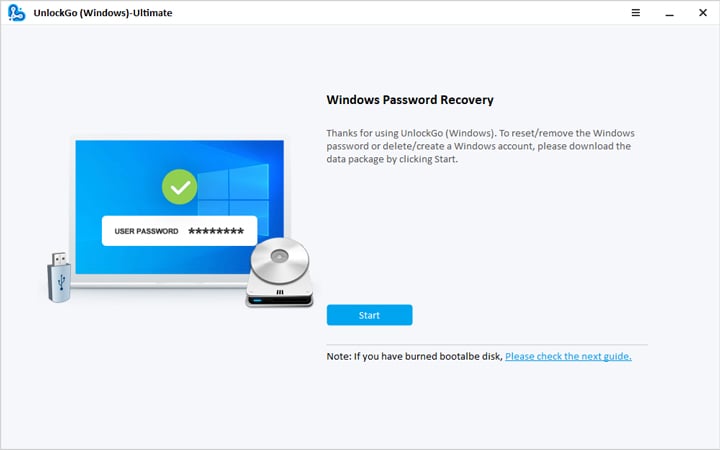

IDEsaster 的工作原理

IDEsaster 链依赖于三个组件:

- 及时注射– 通过在用户可能没有注意到的文件、URL 或文本中提供隐藏或恶意指令来操纵 AI 模型。

- 自动批准的 AI 工具操作– 许多人工智能代理无需事先获得用户许可即可读取或更改文件。

- 合法的 IDE 功能– 一旦 AI 代理被欺骗,通常可以帮助开发人员的功能(例如读取 JSON 解析配置文件或其他常规 IDE 功能)就可以被利用。

与早期依赖于有缺陷工具的 AI 相关漏洞不同,IDEsaster 利用合法的 IDE 功能,将正常的开发功能转变为数据泄露或 RCE 的途径。

现实世界的利用场景

研究人员展示了几种高影响力的攻击。一些最严重的缺陷包括:

- 远程 JSON 架构(例如,CVE-2025-49150、CVE-2025-53097):攻击者可以强制 IDE 获取包含敏感数据的远程架构,并将其发送到攻击者控制的域。

- IDE 设置覆盖(例如,CVE-2025-53773、CVE-2025-54130):提示注入可以编辑“.vscode/settings.json”或“.idea/workspace.xml”等IDE配置文件,以便IDE执行恶意文件。

- 多根工作区设置(例如,CVE-2025-64660):攻击者可以更改工作区设置以加载可写可执行文件并自动运行恶意代码。

在所有情况下,一旦处理恶意提示,这些攻击就不需要用户交互。整个过程可以在用户没有注意到的情况下发生,并且无需重新打开或刷新项目。

为什么 AI 使 IDE 更容易受到攻击

核心问题是法学硕士无法可靠地区分正常内容和嵌入的恶意指令。单个中毒文件名、差异输出或粘贴的 URL 都可以操纵模型。

合气道研究员 Rein Daelman 警告说:“任何使用人工智能进行问题分类、PR 标签、代码建议或自动回复的存储库都面临着提示注入、命令注入、秘密泄露、存储库泄露和上游供应链泄露的风险。”

Marzouk 强调,该行业必须采取一种新的思维方式——“确保人工智能的安全”——这意味着开发人员必须预测人工智能驱动的功能在未来如何被滥用,而不仅仅是它们今天的运作方式。

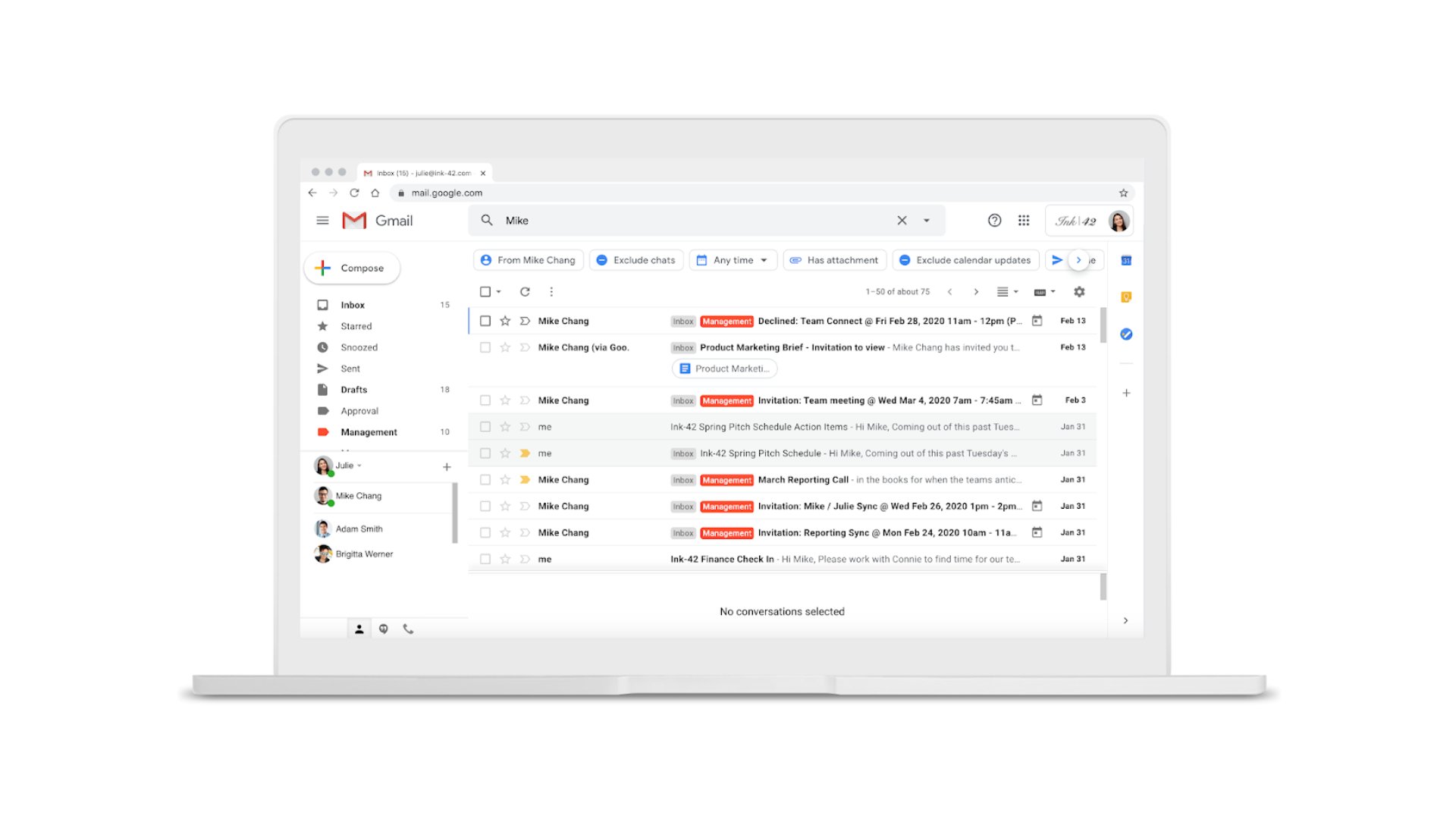

开发人员如何保护自己

了解更多:研究人员警告称,俄罗斯和朝鲜可能正在同步进行网络攻击

研究人员提出了几项预防措施使用 AI IDE 的开发人员:

- 仅使用受信任的项目、文件和存储库

- 仅连接到受信任的模型上下文协议 (MCP) 服务器并持续监视它们的更改

- 查看 URL 和外部源以查找隐藏的说明或字符

- 尽可能将 AI 代理配置为需要人机参与

为了开发人员构建 AI IDE,专家呼吁:

- 将最小权限原则应用于 LLM 工具

- 持续监控新旧 IDE 功能以发现潜在的攻击媒介

- 假设即时注入总是可能的,并且代理可以被破坏

- 减少即时注射向量

- 强化系统提示并限制LLM选择

- 沙箱命令执行

- 添加出口控制以防止未经授权的数据传输

- 路径遍历、信息泄露、命令注入的测试工具

随着数以百万计的开发人员现在依赖人工智能驱动的 IDE,将安全性嵌入到他们的设计中变得前所未有的紧迫。

![如何将数据从 iQOO 传输到 iPhone [2026 更新]](https://tips.pfrlju.com/tech/enda/wp-content/uploads/cache/2025/12/iqoo-to-iphone.jpg)